Desde hace un par de años los medios de comunicación vienen publicando una gran cantidad de artículos sobre una nueva especialidad que contribuye a mejorar la rentabilidad de las organizaciones: se trata del Análisis de datos o Data Analysis & Big Data. Se prevé que en los próximos años aparecerá una gran demanda de profesionales especializados en el análisis de datos porque sus servicios permiten a las organizaciones obtener conocimiento a partir de los datos generados por la propia actividad y, además, a partir de los datos generados por la actividad de todos los agentes del mercado: usuarios, consumidores, competencia, etc.

Pero, ¿qué es en realidad el análisis de datos? ¿qué es lo que convierte esta especialidad en una herramienta tan valiosa?

Cuando preguntamos sobre este tema dentro del mundo de la empresa obtenemos respuestas tan variadas como: “no tengo ni idea” o “es algo que sirve para analizar los datos de la empresa con el objetivo de mejorar el rendimiento”. O también: “es la investigación sobre las tendencias y patrones que se repiten en las grandes cantidades de datos que se generan cada día en Internet”. Resulta difícil encontrar una respuesta única y completa, aunque la idea que subyace siempre apunta a la extracción de información a partir de los datos. Dicho más llanamente, se trata de métodos para obtener conocimiento a partir de lo que pasa en el mundo.

Pero este conjunto de técnicas y metodologías no son nuevas. Hace ya 50 años, John Tukey se dio cuenta de la creciente capacidad de cálculo de los ordenadores y propuso una transformación de la estadística. Hasta ese momento no era posible estudiar grandes cantidades de datos debido a las limitaciones humanas. Había que extraer una muestra, comprobar que fuera representativa de todo el conjunto y estudiarla. Después había que ver si las conclusiones se podían extrapolar a todos los casos. Con la aparición de los ordenadores desaparecen gran parte de estas limitaciones porque permiten automatizar tareas mediante algoritmos y trabajar con todos los datos. En “El futuro del análisis de datos” Tukey propone una ciencia cuyo objetivo es “aprender de los datos”.

Hadley Wickham, reconocido profesor de estadística en las universidades de Standford (EUA) y AUckland (Austalia) y desarrollador de software para analizar datos, afirma que “el análisis de datos es el proceso con el cual los datos resultan comprensibles y se convierten en conocimiento”.

Vivimos en una sociedad cada vez más informatizada y el uso de dispositivos electrónicos para acceder a Internet se extiende cada día a más ámbitos de la vida cotidiana. Esto permite que cualquier evento pueda ser parametrizado y registrado en bases de datos para un análisis posterior o, incluso, inmediato. 1,40 billones de personas se conectan cada día a Facebook, donde se publican 330 millones de fotografías al día y medio millón de comentarios cada minuto. Toda esta actividad se traduce en datos guardados en un sistema informático muy complejo y es posible acceder a él para consultarlo. Pero estos datos no se pueden leer directamente. Para poder extraer conocimiento a partir de ellos deben ser procesados siguiendo determinados procedimientos y, sobretodo, deben ser relacionados con el contexto de origen y con el objetivo del análisis: las preguntas. Solo de esta manera es posible recuperar el sentido que nos va a permitir obtener conocimiento. Las herramientas informáticas hacen posible la parte más técnica y estadística del trabajo, pero éste debe ser planificado desde una perspectiva de negocio porque el objetivo del análisis es generar un conocimiento útil para la toma de decisiones. Un análisis de datos que no tenga un efecto positivo sobre la estructura de la organización no sirve para nada.

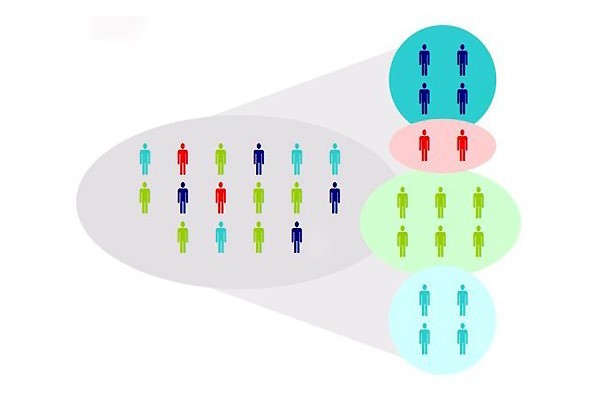

Para ilustrar este proceso, veamos un caso de estudio. Imaginemos una empresa de distribución de productos electrónicos. El departamento de marketing se ha reunido para hablar sobre la página web de la empresa y el ecommerce. El sitio web lleva un año en marcha y es hora de realizar modificaciones pero no hay unanimidad en la dirección que éstos deben tomar. El sistema informático ha registrado toda la actividad de los consumidores pero estos datos “en crudo” no permiten responder a las preguntas que se hace el equipo: no permiten identificar a los diferentes tipos de cliente y, por tanto, no permiten conocer los hábitos de compra de los consumidores. Y se dan cuenta que sin este conocimiento no es posible diseñar campañas de fidelización para los clientes habituales ni campañas de incentivo para los potenciales.

Durante la reunión, el comercial con más experiencia afirma que las personas más jóvenes tienden a comprar más online mientras que las personas mayores tienden a comprar más en la tienda. Otro comercial más joven no está de acuerdo y argumenta que la gente más joven no tiene ingresos suficientes para invertir tanto en tecnología como las personas mayores porqué éstas tienen la hipoteca pagada y los hijos son mayores y ya viven en su propio hogar. Notamos que ambos tienen puntos de vista plausibles, aunque basados en estereotipos y prejuicios, y no encuentran elementos objetivos para decidir las políticas de marketing a seguir.

La responsable de marketing, ante esta situación, busca una solución en Internet y encuentra un artículo como éste dónde puede informarse sobre la utilidad del análisis de datos para solucionar problemas como el suyo. Envía un email a un analista de datos con un resumen de la situación, unas preguntas y un archivo con la información de las 80.000 últimas compras. El analista estudia el email y realiza un análisis exploratorio de los datos mediante una serie de gráficos o visualizaciones. Enseguida se da cuenta que hay una zona geográfica (Z4) dónde solo se dan ventas online y que en otra zona (Z1) se da un volumen muy bajo de ventas online. Entiende que el factor geográfico tiene más peso que el de la edad, con el que sin duda está relacionado. Entonces decide comentar esto con la responsable de marketing, quien le comunica que Z1 fué la zona dónde se abrió el negocio, cuando todavía no existía la venta online, y Z4 todavía no dispone de tiendas físicas. Se confirma la importancia del factor geográfico en relación con los hábitos de compra, un aspecto que había sido considerado de manera inadecuada por los miembros del equipo de marketing. Ahora se ve claramente la necesidad de crear campañas individualizadas para cada región. Cada una tiene una combinación de factores diferentes que exige medidas distintas.

Acabo de presentar un ejemplo muy simple dónde se pone de manifiesto la utilidad del análisis de datos. El analista tiene la capacidad de ver cosas que otros no ven gracias a la combinación de herramientas, métodos y perspicacia.

Una investigación profunda puede ocupar de tres semanas a un mes debido a que se trata de un proceso iterativo a través de una serie de pasos: investigación sobre el problema, exploración de los datos, análisis de intuiciones (“insights” en inglés), construcción de varios modelos matemáticos explicativos que permitan realizar previsiones y escoger el mejor (menos margen de error, más simple, más explicativo, etc…). Y volver a empezar: cuando las intuiciones han sido verificadas y se ha creado un modelo explicativo es necesario volver de nuevo a los datos para mejorar el modelo. De esta manera el analista va penetrando en la realidad de estudio y es capaz de extraer más y mejores resultados que van a permitir orientar mejor la toma de decisiones. Finalmente llega el momento de construir un relato que facilite la presentación de los resultados. Esta suele darse en forma de informes y presentaciones con diapositivas.

Ahora bien, es razonable preguntarse hasta qué punto son fiables los resultados. Se trata de una pregunta inherente a la manera humana de conocer el mundo. El conocimiento siempre es provisional, probabilístico y falible. No obstante, hay herramientas y procedimientos para evaluar la distancia que se abre entre los resultados y la realidad: los índices de error. Éstos nos permiten conocer los márgenes de confianza e incertidumbre en los cuales se mueve el modelo. Es importante entender que no existe la ausencia de error o 100% de fiabilidad y, además, no es deseable. El grado de aproximación a la realidad viene exigido por el problema analizado: no necesitamos la misma precisión en metros cuando buscamos una ciudad que cuando buscamos una tienda. Es muy importante tener consciencia de este punto porqué muchas investigaciones consistirán precisamente en estudiar la dimensión de este error y en buscar métodos para gestionarlo.